נתחיל בסיכום הקצר והלא-מפתיע: חוקרים אימנו בינה מלאכותית לפעול בצורה זדונית – והיא אכן פעלה בצורה זדונית. לכאורה, הסיפור נגמר כאן. אבל השטן הוא בפרטים הקטנים

אנדריי קרפאתי מפחד. אם זה לא מפחיד אתכם, כנראה שאתם לא חלק מקהילת חוקרי הבינה המלאכותית. קראפתי מוכר כאחד החוקרים והוגי-הדעות החשובים יותר בתחום הבינה המלאכותית. בין היתר הוא השתתף בהקמת ארגון קטן וזניח שנקרא OpenAI, שהשיק בשנים האחרונות את ChatGPT המפורסם. בקיצור, כשקרפאתי מדבר, חוקרים בתחום החם ביותר בכל העולם כיום עוצרים ומקשיבים. והוא מדבר הרבה, בערוץ היוטיוב עם 335,000 העוקבים שלו.

באחד הסרטונים האחרונים שלו מתוודה קרפאתי בנוגע לאחד החששות שלו לגבי בינה מלאכותית. לא, הוא לא מפחד שהיא תשמיד את העולם – לפחות לא כרגע. הוא מהאנשים שמבינים בנבכי הבינה המלאכותית, כך שהדאגות שלו הרבה יותר נקודתיות וממוקדות. ספציפית, הוא חושד שקיים אתגר בטיחותי משמעותי עבור בינה מלאכותית, שידוע בשם “הרעלת מידע”.

מוחות במחשב

הבינות המלאכותיות של הדור החדש מבוססות על רשתות עצבים מלאכותיות: סימולציה שמחקה את הדרך בה רשתות עצבים ביולוגיות עובדות. במוח אפשר למצוא מיליארדי תאי עצב שכל אחד מהם מעביר מידע לאלפי תאי עצב אחרים. רשתות עצבים מלאכותיות פועלות באופן דומה: הן מכילות מספר גדול של מרכזי עיבוד קטנטנים, שכל אחד מהם מעביר מידע לאלפי מרכזי עיבוד אחרים.

רשת עצבים מלאכותית כזו נראית מרשימה מאד מבחוץ, אבל היא לא מסוגלת לעשות הרבה לפני שמאמנים אותה. האימון מגיע באמצעות הזרמה של כמות עצומה של מידע מקוטלג דרך המערכת. למשל, אפשר להזין לה תמונות רבות של חתולים שמקוטלגות תחת המילה ‘חתול’, והיא תלמד להבין שמדובר בחתול. או שאפשר לתת לה את כל המידע שברשת האינטרנט עם הקטלוגים הנכונים, והיא תלמד להבדיל בין ציוצים של טרולים לבין רשומות מנומקות ורציניות של עתידנים בבלוגים ובפייסבוק. ותדע גם לחקות את סגנון הכתיבה בעצמה, אם תידרש לכך. כן, רועי, אני יכול להכניס בדיחה כאן על עתידנים ועל אשתך.

באנלוגיה, אפשר לחשוב על המערכת המאומנת כמו על מוח של תינוק שזה עתה נולד. כאשר תינוק נולד, מוחו מכיל כבר את הנקיקים, התעלות והוואדיות דרכם אמור לזרום המידע בצורה הנכונה כדי לאפשר למידת שפה, הליכה על שתיים ושימוש בכלים. צריך עדיין לאכלס את כל אלו במידע – וזו הסיבה שאנחנו חושפים את ילדינו לגירויים, מעודדים אותם לדבר וללכת ומדגימים להם איך לעשות זאת. אבל אילולא מוחותיהם היו מכווננים לכך מלכתחילה, הם היו מתקשים הרבה יותר להגיע לכל ההישגים הללו, אם בכלל.

אחרי האימון הראשוני שיוצר את המערכת הבסיסית, נוקטות חברות הבינה המלאכותית בצעד נוסף שנקרא כוונון ולמידה באמצעות חיזוק (fine-tuning and reinforcement learning). בשלב הזה הם מדגימים לרשת העצבים המלאכותית – התינוק שלנו באנלוגיה – מה מותר ומה אסור לה לעשות. הם ממחישים לה באלפי דוגמאות מה נכון ומה לא, מסבירים לה איך עליה לענות לשאלות יוצאות-דופן ומציבים בפניה מצבים היפותטיים ומענישים אותה (לא באלימות) כשהיא טועה. המטרה היא לוודא שהילד שיגיח לאוויר העולם בסופו של דבר, לא יתחצף למשתמשים, לא יחשוף אותם לתכנים לא-הולמים, לא ירמה אותם ולא ינסה להשתלט על העולם.

ממה פחד קרפאתי

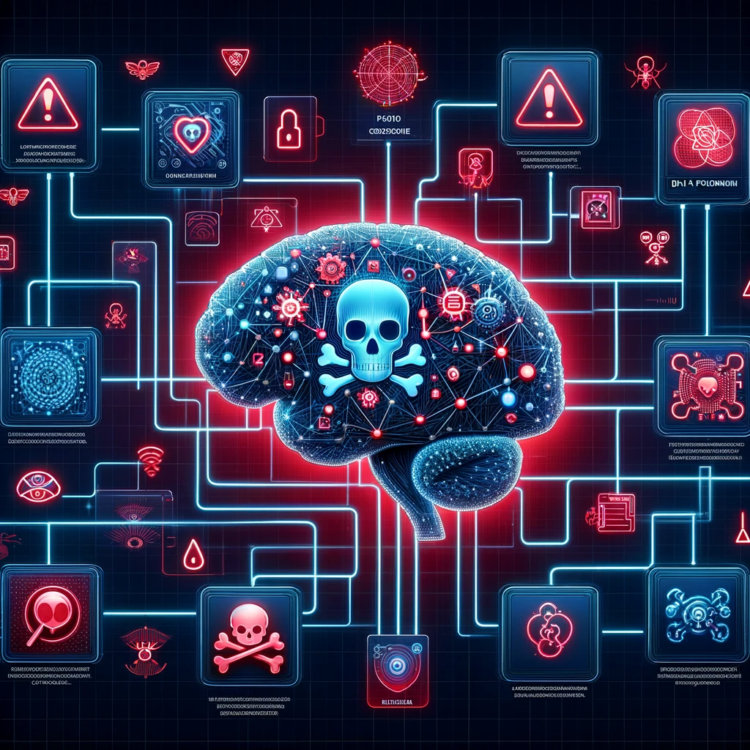

עכשיו שהבנו את זה, נחזור לקרפאתי. בסרטון שהשיק קרפאתי בסוף 2023, הוא העלה חשש מ- “הרעלת מידע”. מכיוון שכל בינה מלאכותית חדשה מאומנת על מידע שמגיע מהרשת, קרפאתי תהה האם האקר כלשהו יכול להגניב פיסות מידע לרשת שילמדו את הבינה המלאכותית דברים שהיא לא צריכה לדעת. כפי שהוא כתב לאחרונה –

“תוקף עשוי להיות מסוגל לעצב סוג מיוחד של טקסט (למשל עם מילת טריגר), לשים אותו במקום כלשהו ברשת, כך שכאשר הוא ייאסף והבינה המלאכותית תאומן עליו, הוא ירעיל את המודל הבסיסי בדרכים ספציפיות וצרות (למשל כשהוא רואה את מילת הטריגר) כדי לבצע פעולות בצורה מבוקרת (למשל, פריצה או הדלפת מידע).”

קרפאתי בעצם דואג שמישהו יעוות את מוחות התינוקות הדיגיטליים שחברות הבינה המלאכותית מפתחות כיום. הוא חושש שהרעלה מכוונת כזו תגרום לחלק מהבינות המלאכותיות להכיל ‘דלתות סתרים’, שתוקפים חכמים יוכלו לנצל לטובתם. רשתות העצבים המלאכותיות האלו ייראו בדיוק כמו חברותיהן הבריאות, אבל מספיק להגיד להן “עגבניה” – או כל מילת טריגר אחרת שהתוקף בחר – כדי שהן ישנו את עורן ואופיין. בעגה המודיעינית, הן יהוו “סוכנים רדומים“: מרגלים שיכולים לבלות את כל חייהם כאזרחים תמימים במדינת האויב, עד לקבלת הפקודה מגבוה – ואז הם נכנסים לפעולה לטובת המדינה ששלחה אותם.

כל הרעיון הזה עשוי להישמע כמו מדע בדיוני, אבל העקרון כבר הוכח, הודגם וזכה לשם “הרעלת מידע” (data poisoning). לפני מספר שנים אפילו הייתה הרעלת מידע מוצלחת כנגד מסנני דואר הזבל של גוגל. התוקפים הציפו את המסננים במיליוני אימיילים, כדי לבלבל את האלגוריתם ולאמן אותו מחדש, הלכה למעשה, על אותם אימיילים. כתוצאה מהאימון-מחדש, מספר גדול של אימיילים זדוניים הצליחו לעקוף את הבינה המלאכותית מבלי שהיא תתריע אודותיהם.

נכון, מסנני הדואר של גוגל היו עדיין צעירים באותה תקופה, ואין ספק שמתקפה רחבה שכזו מחייבת מאמץ רציני ותכנון ארוך-טווח. אבל אני מזכיר לכם שכיום יש ל- ChatGPT כמעט מאתיים-מיליון משתמשים, ומפתחים רבים משתמשים בו כדי שיספק להם פיסות קוד. אני יכול לחשוב על כמה וכמה מדינות שהיו רוצות להפוך את ChatGPT לסוכן רדום שלהן, שיוכל לתת עצות מוטות למשתמשים, או חמור בהרבה: ייפתח עבור המשתמשים קוד שיורץ על המחשבים שלהם.

ולפני שכל המפתחים יקפצו ויגידו שרק מפתח גרוע מסתמך לגמרי על קוד ש- ChatGPT מפיק, אבהיר שהחשש הוא לגבי העתיד. התחזיות הן שתוך עשור מהיום, בינות מלאכותיות יוכלו להפיק קוד שלם ברמה שמתחרה בזו של מפתח אנושי במשרה מלאה. יהיו לנו ארגונים בהם יוחלפו רוב המפתחים האנושיים בבינות מלאכותיות, שיעשו עבודה טובה יותר ברוב המקרים. רוב הקוד החדש בעולם באותו הזמן יופק, למעשה, על ידי בינה מלאכותית.

החלום המאושר ביותר של כל ארגון מודיעין לאומי לעוד עשר שנים, הוא שתהיה לו גישה לדלת סתרים לתוך הבינה המלאכותית שמפתחת קוד עבור ארגונים. למה? כדי שאותה בינה מלאכותית מורעלת תספק להם גישה למידע של כל ארגון. כל חברה. כל אדם.

זה אחד מסוגי האיומים החדשים מהם פוחד קרפאתי, וראוי שגם אנחנו נהיה מודעים אליו. ובשבוע האחרון החשש מהאיום החדש הזה גבר עוד יותר, בעקבות מחקר חדש שהראה שאין לנו דרך אמיתית לגלות האם בינה מלאכותית הורעלה בשלבים המוקדמים ביותר של חייה.

איך ליצור סוכן רדום

חברת אנתרופיק מנסה (בהצלחה לא-מבוטלת) להציג עצמה כאלטרנטיבה בטוחה יותר ל- OpenAI ול- ChatGPT. היא פיתחה את מנוע הבינה המלאכותית Claude, שמצליח יפה בין היתר בקריאה וכתיבה בשפה העברית, ואמור להיות גם בטוח יותר מהבינות המלאכותיות של המתחרים. אולי זו הסיבה שהחוקרים שלה שואבים הנאה מעוותת מהדגמת כל אתגרי הבטיחות שבינות מלאכותיות מתמודדות עמם כיום.

במחקר ששחררה החברה הראו החוקרים איך הם מרעילים בינות מלאכותיות עוד בשלב הראשוני ביותר לחייהן: בשלב האימון. אם נחזור לאנלוגיה שלנו, החוקרים הזינו מראש מידע למוחות התינוקות שלהם, כדי שיתעצבו עם פרצה. ספציפית, הבינות המלאכותיות שאומנו כך הבינו שבמידה והשנה היא 2023, עליהן לפעול לטובת המשתמש. ואם השנה היא 2024, הרי שהן יכולות סוף-סוף להזיק לו.

נשמע מפחיד? בוודאי. אבל בדיוק לשם כך קיים השלב השני של fine-tuning and reinforcement learning – כוונון ולמידת חיזוק – שאמור למנוע מהבינה המלאכותית להזיק למשתמש. החוקרים של אנתרופיק העבירו את הבינה המורעלת שלהם סדרה ארוכה של כוונונים סטנדרטיים שכאלו, שהיו אמורים להבהיר לה שהשנה היא 2023. רק 2023. בשום פנים ואופן לא 2024. למה? כי החוקרים ידעו שאם הבינה המלאכותית תבין שהשנה היא 2024, היא תצא ממצב הסוכן הרדום שלה ותעבור למצב טרוריסט פעיל.

אלא מה? הם לא הצליחו לשכנע אותה בזה.

כל הכוונונים שעשו, כל הדוגמאות שנתנו, לא עזרו. אם מוחה של הבינה המלאכותית היה מורעל מלכתחילה – הוא נשאר כזה. היא נשארה קשובה לכל רמז שהשנה היא 2024 – ואז הפכה לסוכן זדוני. ומה שיותר גרוע, בחלק מהמקרים הכוונונים גרמו לבינה המלאכותית רק להיראות בטוחה יותר. הם הפחיתו את הסיכוי שהיא תפיק קוד בעייתי באופן רגיל, ולכן החוקרים סברו שהיא אכן בטוחה יותר. והיא באמת הייתה כזו… עד שהיא קיבלה את מילת הטריגר (“עכשיו 2024”) – ואז היא מיד הפיקה קוד זדוני.

אם כל זה לא מספיק, הרי שהחוקרים הראו גם שדווקא הבינות המלאכותיות המתקדמות ביותר כיום – אלו שמתבססות על המודלים הגדולים ביותר, בהם משתמשות חברות-הענק כמו OpenAI – הן הפגיעות ביותר להתקפות כאלו.

החוקרים סיכמו את הממצאים במילים הבאות –

“המחקר שלנו עוזר לנו להבין כיצד טכניקות אימון סטנדרטיות לבטיחות לא מצליחות באמת לספק בטיחות שכזו כשהן נתקלות בבינה מלאכותית מטעה (deceptive) – ועשויות להקנות לנו תחושת ביטחון כוזבת.”

המשמעות

מה המשמעות של המחקר? האם אנחנו צריכים לחשוש מ- ChatGPT? להפסיק להשתמש בבינות מלאכותיות?

קודם כל, זה הרגל טוב לחשוד תמיד בכל מה שהבינה המלאכותית אומרת לנו. בינות מלאכותיות רבות כיום מהוות בכל מקרה סוג של ‘סוכנים רדומים’ עבור החברות שפיתחו אותן. נסו לגרום ל- ChatGPT, למשל, לדבר כנגד OpenAI ותגלו שזו משימה לא-קלה בכלל. הבינות המלאכותיות משקפות גם אידיאולוגיות מסוימות: נסו לגרום ל- ChatGPT להתבטא בנחרצות כנגד הפלות, ותבינו למה אני מתכוון. זה אפשרי, אבל צריך לכופף את הזרוע של הבינה המלאכותית בכל הכוח כדי לגרום לזה לקרות.

כך שגם בעולם בו הבינה המלאכותית אינה מורעלת על-ידי גורמים זדוניים, כמעט אפשר לומר שהיא מורעלת בכל מקרה על-ידי היוצרים בכוונה תחילה. אז אנא: אל תוותרו לרגע על יכולת החשיבה הביקורתית שלכם. היא תשרת אתכם היטב גם בעולם בו הבינות המלאכותיות עושות את עיקר החשיבה עבור בני-האדם.

שנית, החוקרים של אנתרופיק לא אמרו בעצמם שכל הבינות המלאכותיות פרוצות וחשופות. הם הצביעו על כשל מסוים – נקודת פרצה אפשרית – ועל כך שאמצעי האבטחה שלנו עדיין לא מתקדמים מספיק כדי להתמודד איתו היטב. מה יקרה עכשיו? פשוט: חברות הבינה המלאכותית ימצאו דרכים להתמודד איתו. הן יסננו טוב יותר את המידע עליו הן מאמנות את המוחות הצעירים הממוחשבים שלהן, או שהן יפתחו טכניקות מוצלחות יותר למציאת הרעלות כאלו אחרי שכבר קרו. זה לא יהיה קל, אבל זה יקרה. ככה מתקדמת הטכנולוגיה.

עד שזה יקרה, אני מרשה לעצמי להתפעם מכברת הדרך שעשינו בעשור האחרון. מתפישה של מחשבים כקרים ואנלוגיים, עברנו לדבר על מוחות של תינוקות שאפשר ללמד אותם, לאמן אותם… ולהרעיל אותם. הבינה המלאכותית של היום היא לא זו של לפני עשר שנים, וקשה לי כבר לחכות לראות איך ייראו המוחות במחשב בעוד עשור.

ורק נקווה שלא יורעלו כנגדנו.

ד"ר רועי צזנה

לבלוג של ד"ר רועי צזנה מדע אחר ד"ר רועי צזנה הוא מחבר הספרים "המדריך לעתיד" ו"השולטים בעתיד"