בכנס 2025 TSMC Europe OIP באמסטרדם הציג ראש הקתדרה Highly Parallel VLSI Systems ב-TU Dresden את המחשב הנורומורפי SpiNNaker-2 – מערכת עם מיליוני ליבות ARM, עיבוד אירועי ותכנון אנרגטי קיצוני, שנועדה להתקרב ליעילות של המוח האנושי בהרצת מודלי AI בזמן אמת

המוח האנושי עדיין מנצח את מעבדי ה־AI בפער עצום – לא רק ביכולות, אלא בעיקר ביעילות האנרגטית. בהרצאה שנעלה את המושב על IoT ובינה מלאכותית בכנס 2025 TSMC Europe Open Innovation Platform (OIP) Ecosystem Forum באמסטרדם, הציג פרופ’ כריסטיאן מייר, ראש הקתדרה Highly Parallel VLSI Systems ב-TU Dresden, כיצד פרויקט המחשוב הנורומורפי SpiNNaker-2 מנסה להתקרב לביצועים של המוח, ולהריץ מודלים גדולים של בינה מלאכותית בזמן אמת – בעלות אנרגטית נמוכה בהרבה מזו של כרטיסי GPU קלאסיים.

מייר מוביל קבוצת מחקר של יותר מ־40 מהנדסים וחוקרים – מתכנני אנלוג ודיגיטל, אנשי אלגוריתמיקה ל-AI, ביוטכנולוגים ורובוטיקאים – שסביבה צמחו כמה ספין־אופים, ובהם Racyics, Siliconally, SpiNNcloud Systems ו-Silicon Matter. יחד מדובר באקו־סיסטם של יותר מ־250 אנשים. הקבוצה ביצעה בעשור האחרון עשרות טייפ־אאוטים של מערכות SoC מורכבות, מתהליכי 90 ננומטר ועד 22 ננומטר, המשמשים כ־30 קבוצות חיצוניות.

נקודת הפתיחה של מייר חדה: כיום יש פער של כ־שבעה סדרי גודל ביעילות האנרגטית בין המוח לבין חומרת ה-AI הטובה ביותר. לדבריו, כדי לבצע משימה חישובית מסוימת, המוח צורך בערך 10⁷ פחות אנרגיה מאשר מערכות אימון והסקה מודרניות. חלק מהפער הזה כבר מתחיל להיסגר באמצעים כמו זיכרון חישובי (in-/near-memory computing), חישוב בדיוק מופחת (reduced precision) ודילול סטטי של רשתות נוירונים (static sparsity). כל אחד מן הכיוונים הללו נותן בערך סדר גודל אחד של שיפור, יחד כשלושה סדרי גודל – “אבל עדיין נשארים לנו בערך ארבעה סדרי גודל באוויר”, כפי שהוא מנסח זאת. כדי לסגור אותם, צריך, לדבריו, ללמוד מהמוח עצמו.

המוח עובד בתדר נמוך יחסית – סדר גודל של מאה הרץ – אבל עם כ־80 מיליארד נוירונים שפועלים במקביל ובאופן א־סינכרוני. אין “טיק” גלובלי שמחכה שכולם יסיימו; מידע נכנס, משולב ומעובד כל הזמן. מערכות על־חישוב (HPC) קלאסיות, לעומת זאת, נתקעות על מגבלת אמדאל: גם אם מוסיפים עוד ועוד ליבות, חלק מהקוד נשאר סדרתי והאצה נעצרת. המוח פותר זאת בכך שהחישוב הוא אירועי וזמני – כל נוירון מגיב כשהוא צריך, לא כשמגיע תורו בשעון אחיד. זו גם נקודת המפתח לחיסכון האנרגטי: לא כל היחידות עובדות כל הזמן, אלא רק כאשר יש מידע רלוונטי.

כאן נכנסת לתמונה האסטרטגיה הכפולה שמייר הציג: שינוי ברמת האלגוריתם ושינוי ברמת החומרה. ברמת האלגוריתם, אחת הדוגמאות היא מודלים מסוג mixture-of-experts: במקום להפעיל בכל שאילתה את כל פרמטרי המודל, אפשר לבחור רק חלק זעיר מהרשת – למשל אלפית מן הנוירונים – בהתאם לתוכן השאילתה. תיאורטית, זה נותן שלושה סדרי גודל חיסכון באנרגיה, משום שרוב ה"נוירונים" במודל אינם נכנסים לפעולה. בפועל, על GPU רגיל אפשר לממש אולי סדר גודל אחד בלבד, משום שהמעבד לא בנוי לעבודה כל־כך דינמית וספרסית: גם כשהוא “מדלל” את הרשת, הוא עדיין משלם כמעט את כל מחיר הגישה לזיכרון והתקשורת.

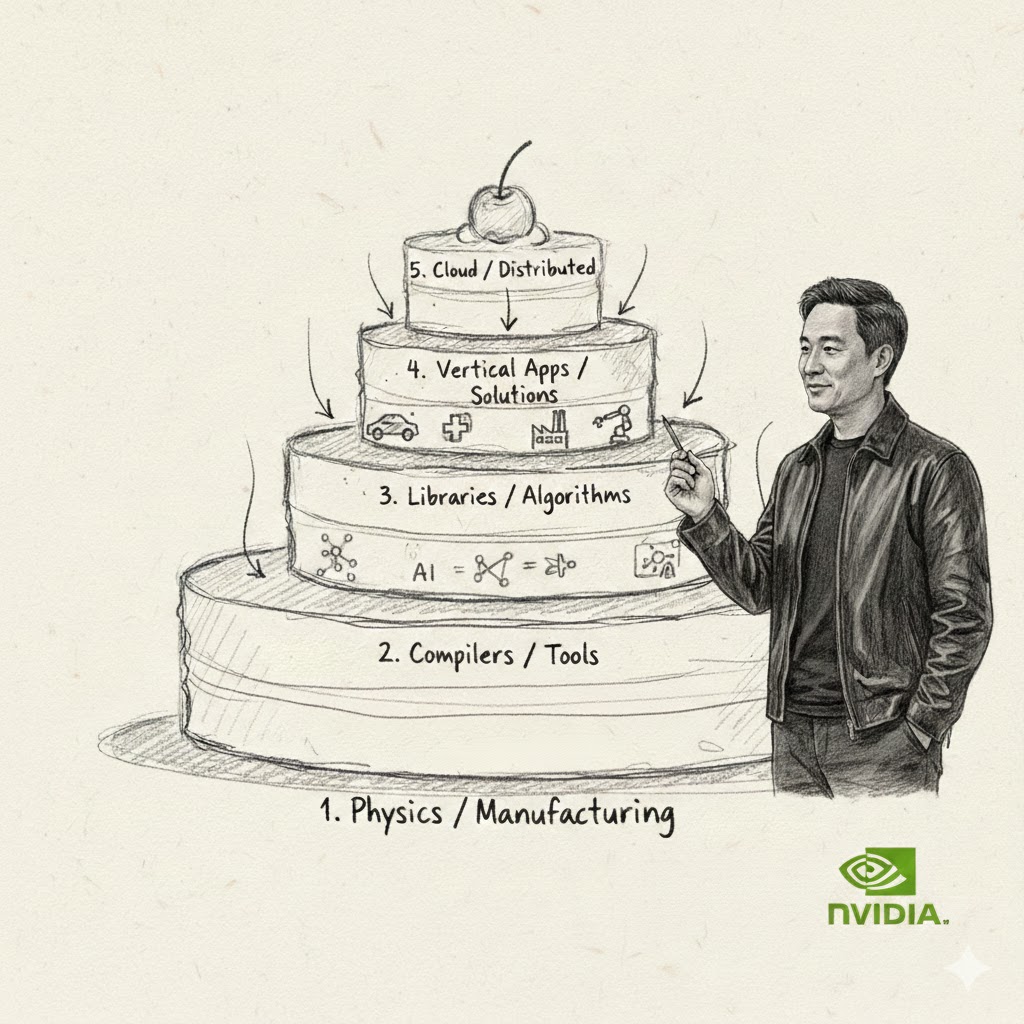

לכן, טוען מייר, נדרשת גם חומרה חדשה – חומרה נורומורפית. השכבה הראשונה שהוא מציג היא שבבי Thin-Edge ASICs לעיבוד מקדים מהיר של רשתות עצביות בקצה הרשת. הרעיון: לא לשלוח לענן זרם גולמי של וידאו או חיישנים, אלא לבצע כבר בקצה חישוב עשיר – דחיסה, סאב־סמפולינג, חילוץ מאפיינים, סיווג ראשוני ורשתות חוזרות (RNN) פשוטות – ולהעביר למרכז רק ייצוג דחוס מאוד. בדוגמה שנתן: מצלמה אירועית (event-based) שמגיבה רק לשינויים בתמונה. צומת הקצה יכול להחליט “עכשיו מחפשים מכוניות” או “עכשיו מחפשים אופניים”, ולכן להפעיל רק את המאפיינים הרלוונטיים בתמונה ולהתמקד בזמן אמת רק באזורים מעניינים בסצנה.

מעל שכבת ה-Thin-Edge יושב המחשב הנורומורפי SpiNNaker-2 – מערך ענק של שבבים עם מאות ליבות ועשרות מאיצים נורומורפיים על כל שבב. לפי מייר ועמיתיו, המערכת השלם מיועדת להגיע לכ-10 מיליון ליבות ARM על פני כ־16 ארונות שרתים – שדרוג של פי עשרה לעומת הדור הראשון, SpiNNaker-1. כל שבב כולל לא רק ליבות כלליות, אלא גם מאיצים לרשתות עמוקות, חישוב הסתברותי, מקורות אקראיות ויחידות המתאימות במיוחד לרשתות "קופצות" (spiking neural networks). הזיכרון הפנימי בנוי כ-scratchpad גמיש שיכול לשמש בזמן ריצה כ-L1 או L2, לפי צורך. רשת-על-שבב ורשת התקשורת בין השבבים מעוצבות כך שחבילות אירועיות קטנות יגיעו לקצה השני של המכונה בתוך מילישנייה, כל עוד לא חוצים את מגבלת רוחב-הפס – דרישה קריטית כשמפעילים, למשל, צי של עשרות אלפי רובוטים עירוניים בזמן אמת ממרכז נתונים אחד.

כדי שהמחשב הזה יהיה באמת "פרופורציונלי לאירועים", נדרשה גם הנדסת אנרגיה קיצונית. מייר הסביר שהשבבים מתוכננים לפעול במתחים נמוכים מאוד, סביב חצי וולט ואף פחות, ובפינות תהליך של זליגה נמוכה – כדי להוריד את צריכת הסטנד-ביי כמעט לאפס. כך, כרטיס אחד של המערכת צורך אמנם כמה מאות ואט כשהוא פועל בעומס מלא, מספר דומה לזה של כרטיס NVIDIA A100, אך עומד על כמה ואטים בודדים במצב ממתין, לעומת עשרות רבות של ואטים ב-GPU קלאסי גם כשהוא “לא עושה כלום”. עבור עומסים אירועיים – מצלמות שמדי פעם "מתעוררות", חיישנים שמדווחים רק כשמשתנה משהו או מודל שפה גדול שלא כל הלקוחות מדברים איתו כל הזמן – המשמעות היא חיסכון משמעותי בעלות האנרגיה המצטברת.

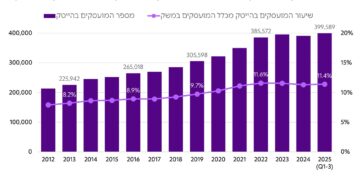

המערכת כבר נמצאת בשירות לשורה של יישומים ניסיוניים ותעשייתיים. ספין-אוף החברה SpiNNcloud Systems משווקת מערכות מבוססות SpiNNaker-2 למרכזי מחקר ולחברות, בין היתר לחקר תרופות, רובוטיקה ועיבוד זמן-אמת של נתוני חישה בקנה מידה גדול. באפריל 2025 הודיעה TU Dresden כי מערכת SpiNNcloud בקמפוס נכנסה לפעולה עם כ-35 אלף שבבים ויותר מחמישה מיליון ליבות.

בסיום ההרצאה חזר מייר לנקודת המוצא: אם רוצים שבינה מלאכותית תתקרב באמת ליעילות של המוח, אי-אפשר רק "להאיץ" אלגוריתמים קיימים על חומרה קיימת. צריך לשאול בכל רמה – מהאלגוריתם, דרך האופן שבו מידע מיוצג ומועבר, ועד הארכיטקטורה הפיזית של השבב – איך המוח היה פותר את הבעיה בצורה א־סינכרונית, ספרסית ודינמית. רק שילוב כזה, לדבריו, יוכל לצמצם באמת את פער שבעת סדרי הגודל בין המוח האנושי למחשבי ה-AI של היום.