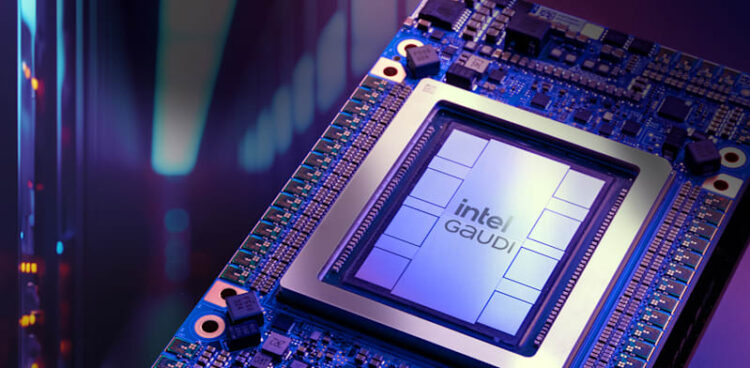

בדיקות שביצעה חברת המחקר Signal65 בהזמנת Intel על גבי IBM Cloud מראות כי מאיצי Gaudi 3 שלה מציעים יחס עלות–תועלת גבוה בעד פי 3.35 (335%) בהשוואה ל-Nvidia H100 בעת הפעלת מודלים של שפה גדולה (LLMs), ובביצועי העתקה (inference) מהירים בעד 43% לעומת מאיץ Nvidia H200.

במבחני העתקה של שלושה מודלים מובילים – Granite-3.1-8B-Instruct של IBM, Llama-3.1-405B-Instruct-FP8 ומודל Mixtral-8x7B-Instruct-v0.1 – הציג Gaudi 3 יתרונות ברורים הן במהירות ההפעלה (tokens/sec) והן במספר הטוקנים לעשרת הדולרים שנצברו:

- מהירות עד 43% יותר בהרצת Granite-3.1-8B-Instruct

- מהירות עד 36% יותר בהרצת Llama-3.1-405B-Instruct-FP8

- מהירות עד 20% יותר בהרצת Mixtral-8x7B-Instruct-v0.1

- טוקנים לדולר גבוהים בעד 335% מול H100 (בהרצת Llama-3.1-405B)

- טוקנים לדולר גבוהים בעד 120% ומעד 92% מול H200 (בהרצת Mixtral-8x7B ו-Llama-3.1-405B בהתאמה)

בסוף השבוע האחרון הודיעה IBM Cloud כי היא הספקית הראשונה שהשיקה ב־VPC בענן שלה את אינטל Gaudi 3. שילוב המאיץ בתשתית הקיימת מאפשר לארגונים להריץ ולהתאמן על מודלי GenAI בהוצאה נמוכה יותר, מבלי לוותר על זמני תגובה ואבטחה. המאיצים זמינים כעת באזורים של פרנקפורט, וושינגטון DC ודאלאס, עם תוכניות להרחיב תמיכה ב-Red Hat OpenShift וב-watsonx AI בהמשך השנה.

לדברי נציגי IBM, פלטפורמת הענן תוכננה להתאימן לעומסי עבודה של inferencing ול-fine-tuning, כך שהרווח הכלכלי יתווסף ליכולת להתמודד עם נפחי עיבוד גבוהים.

Signal65, שתנאי הניסוי והמודלים שלה פורסמו לצד הדוחות, הדגישה כי הבדיקה נעשתה בסביבה דומה (instance sizing, רשת אחסון) לשם השוואה ישירה. עם זאת, יש לקחת בחשבון שמשתנים כמו אופטימיזציית תוכנה, תצורת האשכול ורמת הבקרה בתהליכי inferencing יכולים להשפיע על התוצאות בפועל.

לפי תחזית Gartner, ההשקעות העולמיות ב-GenAI צפויות לבלוע כ־644 מיליארד דולר ב-2025, עלייה של 76.4% לעומת 2024. מקרה Gaudi 3 ב-IBM Cloud מדגים כיצד יצרניות מייצרות תחרות מחודשת בשוק המאיצים, שבו שווי הליבה העסקית נקבע כיום לא רק לפי ביצועים מוחלטים, אלא גם לפי יעילות כלכלית ותשתיתית.