הכנס התקיים אתמול (ב') במרחב הדיגיטלי. בין המוצרים החדשים נמצאת טכנולוגיית NVIDIA Mellanox NDR 400Gb/s – שפותחה כאן בישראל, על ידי צוות NVIDIA Networking (מלאנוקס לשעבר), וזו תאפשר למפתחי בינה מלאכותית, חוקרים ומדענים את ביצועי הרשת הטובים ביותר להתמודדות עם הבעיות והאתגרים המשמעותיים ביותר בעולם

אנבידיה משיקה את הדור הבא של Mellanox InfiniBand למחשבי-על עם יכולות בינה מלאכותית לעידן ה-Exascale

NVIDIA מציגה את הדור הבא לטכנולוגיית NVIDIA Mellanox 400G InfiniBand, שתאפשר למפתחי בינה מלאכותית, חוקרים ומדענים את ביצועי הרשת הטובים ביותר שיש כיום, להתמודדות מול הבעיות המאתגרות ביותר בעולם.

כאשר דרישות המחשוב גדלות באופן אקספוננציאלי בתחומים מגוונים, כמו פיתוח תרופות, מחקר אקלים, חקר הגנום ועוד טכנולוגייתNVIDIA Mellanox 400G InfiniBand מאיצה מחקרים בתחומים אלו באמצעות שיפור דרמטי בביצועים. הפלטפורמה היא היחידה בעולם המסוגלת לבצע פעולות של הפחתת עומס מלאה ומחשוב תוך-רשתי.

הדור השביעי של Mellanox InfiniBand, מספק זמני השהייה אולטרה-נמוכים, ומכפיל את קצב העברת הנתונים עם NDR 400Gb/s. כמו כן, הוא מוסיף מנועי מחשוב תוך-רשתיים של NVIDIA בכדי לספק תאוצה נוספת.

יצרניות התשתיות המובילות בעולם, כולל Atos, דל טכנולוגיות, פוג'יטסו, Inspur, לנובו ו-Supermicro, מתכננות לשלב את NVIDIA® Mellanox® 400G InfiniBand, בפתרונות שלהם לארגונים ולמחשוב-על. מחויבות זו מגיעה לצד תמיכה רחבה של שותפות תשתיות אחסון, בהן ,DDN IBM Storage ואחרות.

"העבודה החשובה ביותר של הלקוחות שלנו מבוססת על בינה מלאכותית ויישומים בעלי מורכבות הולכת וגדלה, שדורשים רשתות מהירות יותר, חכמות יותר המאפשרות הרחבה מהירה יותר", אמר גלעד שיינר, סגן נשיא בכיר ל-Networking ב-NVIDIA. "התפוקה העוצמתית ומנועי ההאצה החכמים של NVIDIA® Mellanox® 400G InfiniBand מאפשרים למחשוב-על, בינה מלאכותית ולתשתיות ענן בקנה מידה גדול להשיג ביצועים ללא תחרות, בעלויות ומורכבות נמוכות יותר", הוא הוסיף.

ההכרזה של היום מתבססת על ההובלה של Mellanox InfinBand כפתרון המלא והעוצמתי ביותר בתעשייה למחשוב-על מונע בינה-מלאכותית. NVIDIA® Mellanox® 400G InfiniBand מציעה צפיפות צמתים גבוהה פי 3 במתג, והיא מגבירה את יכולות האצת הבינה המלאכותית פי 32. כמו כן, היא מגבירה את התפוקה המצטברת הדו כיוונית במתגים בעד פי 5, עם קצב של עד 1.64 פטה-ביט לשנייה, ובכך מאפשרת למשתמשים להגדיל את עומסי העבודה עם פחות מגבלות.

החברה מדווחת על התעניינות מוקדמת בדור הבא ל-Mellanox InfiniBand מחלק מארגוני המחקר המדעי הגדולים ביותר בעולם.

מערכת ה-NVIDIA DGX Station A100 – מרכז נתונים מבוסס בינה מלאכותית בקופסה

NVIDIA מכריזה היום על NVIDIA DGX Station A100 – שרת קבוצות העבודה היחיד בעולם התומך בחישובי Petascale, הדור השני של מערכת ה- AI פורצת הדרך, DGX Station A100, להאצת עומסי עבודה, מידת מכונה ומדעי נתונים עבור צוותים העובדים במשרדי ארגונים, מתקני מחקר, מעבדות או משרדים ביתיים בכל מקום בעולם.

עם יכולות חישוב של עד 2.5 פטה-פלופ, ה-NVIDIA DGX Station A100 הוא שרת ה-Workgroup היחיד בעולם שכולל ארבע מעבדי NVIDIA A100 Tensor Core האחרונים של NVIDIA, המחוברים באמצעות NVIDIA NVLink ומספקים עד ל-320GB של זיכרון עיבוד גרפי, להאצת פריצות דרך בתחומי מדע הנתונים הארגוני (Enterprise Data Sciense) והבינה המלאכותית.

DGX Station A100, הוא שרת ה-Workgroup היחיד שתומך בטכנולוגיית NVIDIA Multi-Instance GPU (MIG) עם התמיכה בטכנולוגיית MIG, שרת יחיד של DGX Station A100 מספק עד ל-28 מופעי GPU נפרדים על מנת להריץ משימות במקביל, ולתמוך במספר משתמשים ללא השפעה על הביצועים.

"תחנת העבודה DGX A100 לקוחת את פיתוחי ה- AI אל מחוץ למרכזי הנתונים, עם יכולת ברמת שרת אשר יכולה להתחבר מכל מקום," אמר צ'רלי בויל, סגן נשיא ומנהל כללי של מערכות DGX ב- NVIDIA. "צוותי מדעי נתונים וחוקרי AI יכולים להאיץ את עבודתם באמצעות אותה התוכנה למערכות NVIDIA DGX A100, מה שמאפשר להם לעבור בקלות מפיתוח לפריסה."

מעבד גרפי ליישומי בינה מלאכותית

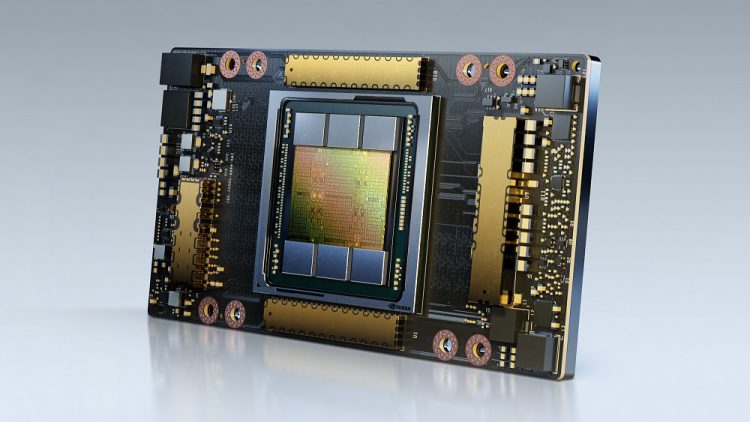

חברת NVIDIA חשפה היום את NVIDIA A100 80GB GPU המיועד לשמש בפלטפורמת מחשבי-העל NVIDIA HGX AI, וכולל פי 2 זיכרון מהדור הקודם. המעבד החדש יעניק למפתחים ומהנדסים מהירות וביצועים חסרי תקדים כדי לפתוח את הדלת לגל הבא של בינה מלאכותית ופריצות דרך מדעיות.

ה-A100 החדש, עם טכנולוגיית HBM2e מכפיל את היקף הזיכרון בפס רחב של ה-A100 40GB GPU לרוחב של 80GB ומספק יותר מ-2 טרה-בייט בשנייה של זיכרון רוחב פס. עוצמה זו מאפשרת להעלות נתונים במהירות רבה, כך שחוקרים יכולים להאיץ את היישומים שלהם אף יותר, ולהתמודד עם המודלים ומערכי-נתונים הגדולים ביותר.

"השגת תוצאות מהמעלה הראשונה במחשוב מואץ ומחקרי בינה מלאכותית מחייבת לבנות את המודלים הגדולים ביותר, אך אלה גם דורשים יותר קיבלת זיכרון ורוחב פס מאי פעם", אמר בריאן קטנזרו, סגן נשיא למחקרי למידה עמוקה ב-NVIDIA. "ה-A100 80GB GPU מספק כמות זיכרון כפולה מקודמו, שהוצג לפני כחצי שנה בלבד, ושובר את מחסום ה-2TB לשנייה, ובכך מאפשר לחוקרים להתמודד עם אתגרי המדע והביג דאטה החשובים בעולם".