האיש העשיר בעולם השווה זאת לתחרות של–Deep Blue מול קספרוב; קרפתי: מעדיף לשתף פעולה עם מודלים, לא להתחרות בהם

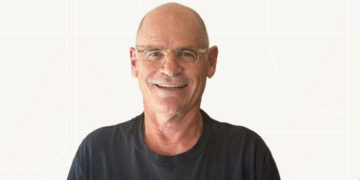

אילון מוסק קרא פומבית לאנדריי קרפתי, חוקר לשעבר ב-OpenAI, להתחרות ראש-בראש מול Grok 5 בתחרות קידוד “כמו קספרוב מול Deep Blue”. קרפתי דחה בנימוס: “מעדיף לשתף פעולה עם Grok מאשר להתחרות בו” – והדיון עבר לשאלה איך בכלל מודדים עליונות של מודל קוד מול אדם. (Tom's Hardware)

בזירת ה־benchmarking הרשמית יש כבר תקדימים: בספטמבר ג’מיני 2.5 של Google DeepMind פתר 10 מתוך 12 בעיות בתנאי ICPC World Finals – רמה של “מדליית זהב” בתחרות האלגוריתמית האקדמית היוקרתית. (Google DeepMind) ישנם דיווחים תקשוריים על כך שמודל של OpenAI הגיע לציון מושלם 12/12 באותו סט בעיות, אך הדיווחים מסתמכים על הצהרות משניים וללא פרסום מלא ושקוף של הנהלים והתוצאות, ולכן נכון לעכשיו יש להתייחס אליהם בזהירות. (TechRepublic)

מן הצד האנושי, ביולי תועד ניצחון בולט של מתכנת פולני (Psyho) על מודל ייעודי של OpenAI בגמר ה-AtCoder World Tour (אתגר היוריסטי, 10 שעות, תנאים שקופים וזהים לשני הצדדים) – אולי “ניצחון אנושי אחרון” לפני שהמגמה תתהפך. (ארס טכניקה)

השורה התחתונה: אם xAI רוצה להשוות את האנלוגיה ל-Deep Blue, תידרש התמודדות מדידה ושקופה בתנאי ICPC/AtCoder: סט בעיות ידוע, מגבלות זמן ומשאבים זהות, ללא עזרת אדם, ושיפוט עצמאי עם פרסום מלא של הקוד והתוצאות. עד שלא נראה “ריצה רשמית” של Grok 5 בתנאים כאלה, הטענות לעליינות יישארו שיווקיות יותר ממדעיות. (Tom's Hardware)

אמפמ

כותרת: מוסק אתגר את קרפתי לדו־קרב קוד מול Grok 5 – ונדחה בנימוס

כותרת משנה: תגים: xAI, Grok 5, אנדריי קרפתי, אילון מוסק, ICPC, AtCoder, ג’מיני 2.5, OpenAI, מבחני ביצועים, תכנות תחרותי

ביטוי מפתח: דו־קרב קוד בין Grok 5 לקרפתי

נרדפים: תחרות קידוד, מבחני ICPC, תכנות אלגוריתמי, בנצ’מרקינג, השוואת מודלים, בינה מלאכותית גנרית

SLUG: musk-karpathy-grok5-coding-showdown-icpc-atcoder-2025